这里的“拆机”不仅仅是指物理上拆开设备,更是从硬件架构、核心技术原理、软件生态等多个维度,剖析这款划时代的增强现实设备是如何工作的。

(图片来源网络,侵删)

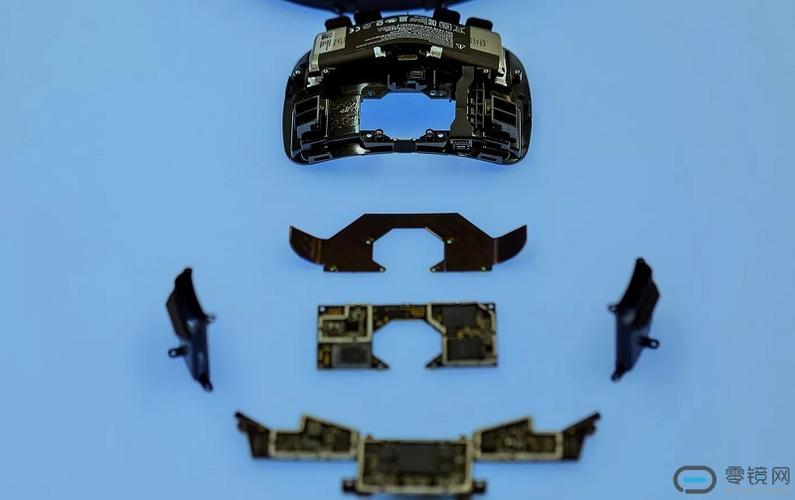

第一部分:物理拆解与核心硬件组件

HoloLens 的设计非常精密,集成了大量尖端技术,我们先从物理硬件入手,了解它的“五脏六腑”。

外观与主要模块

HoloLens 可以大致分为几个核心区域:

- 光引擎: 位于设备前部,这是整个设备的核心,包含了所有用于看到虚拟世界的传感器和显示单元。

- 处理单元: 位于设备后部上方,包含 CPU、GPU、HPU 以及散热系统。

- 传感器阵列: 分布在设备各处,包括头部、面部和环境感知。

- 音频系统: 位于设备两侧的骨传导扬声器。

- 电池与供电: 位于设备后部下方,提供电力。

核心硬件详解

A. 光引擎 - “眼睛”与“画笔”

这是 HoloLens 最复杂、最核心的部分,负责将数字图像叠加到你的真实视野中。

(图片来源网络,侵删)

-

显示技术:

- 两个全高清 (1080p) 光学透视显示器: 一个用于左眼,一个用于右眼,它们不是传统屏幕,而是衍射光学光导,光线从微型投影仪发出,经过光导内部复杂的衍射图案,最终以特定的角度进入你的眼睛,实现“看穿”屏幕的效果。

- 色彩: 早期版本(HoloLens 1)的显示是单色(黑白)的,因为彩色光导技术在当时成本和成熟度上难以平衡,HoloLens 2 引入了全彩色显示,这是其一大进步。

-

传感器系统 - 环境感知:

- 深度传感器: 这是 AR 设备的灵魂,HoloLens 使用的是飞行时间传感器,它主动发射红外光,通过测量光线返回的时间差来精确计算周围环境的深度信息,从而知道物体在哪里、多远,这为虚拟物体的“锚定”提供了基础。

- 四颗环境摄像头: 分布在光引擎周围,提供广角、彩色视频流,用于 SLAM(同步定位与地图构建)和手势识别。

- 惯性测量单元: 包含加速度计和陀螺仪,用于精确追踪你头部的位置和旋转方向。

B. 处理单元 - “大脑”

HoloLens 的计算能力非常强大,专门为 AR 任务进行了优化。

(图片来源网络,侵删)

- CPU: 采用英特尔低功耗 x86 处理器,负责运行 Windows 操作系统和通用计算任务。

- GPU: 负责渲染 3D 图形,将虚拟世界绘制出来。

- HPU (Holographic Processing Unit) - 全息处理单元: 这是 HoloLens 的独门绝技,也是其真正的“大脑”,它是一个专门为 HoloLens 设计的协处理器。

- 功能: HPU 拥有 24 个定制内核,每秒可进行 1 万亿次运算(1 TeraFLOPS),它专门负责处理传感器数据(深度、摄像头、IMU),执行 SLAM 算法,追踪头部和手势,并管理整个混合现实体验,将这些实时性要求极高的任务从 CPU 和 GPU 中解放出来,是 HoloLens 能流畅运行的关键。

- 演变: HoloLens 1 的 HPU 是第一代,而 HoloLens 2 的 HPU 升级到第二代,性能和能效都大幅提升。

C. 交互系统 - “感官”

- 手势识别:

- 通过四个环境摄像头捕捉你的手部动作。

- 内置的 AI 算法(运行在 HPU 上)实时识别和追踪你的手指、手掌,理解空中点击、握持等手势。

- 眼动追踪:

- HoloLens 2 新增的功能,通过内置的红外摄像头和传感器追踪你的眼球注视点。

- 作用:

- 实现“凝视选择” (Gaze Selection): 看到哪里,就选择哪里,交互更自然。

- 渲染优化: 只对用户正在注视的区域进行高精度渲染,节省计算资源。

- 数据分析: 了解用户在应用中的注意力焦点。

- 语音识别:

集成了多个麦克风阵列,支持 Cortana 语音助手,可以通过语音命令进行导航和交互。

- 空间音频:

- 使用骨传导扬声器,声音不堵塞耳朵,让你能同时听到虚拟声音和真实环境音。

- 音频引擎会根据虚拟声源的位置和你的头部朝向,模拟出 3D 空间音效,让你感觉声音来自某个特定的虚拟物体。

D. 其他组件

- 电池: 可拆卸设计,方便更换,续航是其一大挑战,通常在 2-3 小时左右。

- 散热: 采用热管和均热板设计,将 HPU 和 CPU 产生的热量高效传导到设备外壳进行散热,确保性能稳定。

- 连接: 支持 Wi-Fi 802.11ac 和蓝牙。

第二部分:核心技术原理 - “魔法”是如何实现的?

了解了硬件,我们再深入一层,看看这些硬件是如何协同工作,创造出混合现实的。

SLAM (同步定位与地图构建) - 空间感知的基石

这是 AR 设备最核心的技术,没有 SLAM,就没有稳定的 AR 体验。

-

过程:

- 初始化: HoloLens 开机时,会通过深度传感器和摄像头“扫描”周围环境,识别出平面(如地面、桌面)和特征点(如桌角、墙上的画)。

- 构建地图: HPU 会将这些特征点组合成一个实时的、三维的环境地图。

- 自我定位: IMU 传感器追踪你的头部移动,SLAM 算法会将你的头部运动与地图上的特征点进行匹配,从而精确计算出你在空间中的位置和朝向。

- 持续更新: 你在空间中移动时,HoloLens 不断更新地图,并根据新的信息修正自己的位置,这个过程是持续不断的。

-

结果: 通过 SLAM,HoloLens 知道了“我在哪里”以及“周围有什么”,这是虚拟物体能够“固定”在真实世界中的前提,你走到桌子旁边,虚拟杯子依然在桌子上,而不是跟着你移动。

光场显示 - 看到真实的深度感

为什么 HoloLens 里的虚拟物体看起来是“立”在真实世界里的,而不是像贴在屏幕上的画?

- 传统屏幕 vs. HoloLens:

- 传统屏幕: 所有光线都来自一个平面,无论虚拟物体多远,它给你的视觉焦点(vergence distance)都是屏幕的距离,这会导致“辐辏-调节冲突”(Vergence-Accommodation Conflict),即眼睛的聚焦距离和汇聚距离不匹配,长时间观看会感到疲劳。

- HoloLens: 它的光学引擎模拟了真实物体发出的光线,当你观察一个虚拟物体时,它的光线会根据你与它的距离,以不同的角度进入你的眼睛,你的眼睛会自然地进行聚焦和汇聚,就像看真实物体一样,从而消除了冲突,带来了更舒适、更真实的深度感知。

空间锚点 - 让虚拟物体“生根”

SLAM 告诉了 HoloLens 空间的结构,但如何让一个虚拟杯子“它放在了桌子的哪个位置?

- 原理: 当你放置一个虚拟物体时,HoloLens 会在它周围的 SLAM 地图上创建一个“锚点”,这个锚点不是绝对坐标,而是相对于环境特征点(如桌角)的相对位置。

- 稳定性: 当你离开再回来时,SLAM 系统会重新识别环境特征点,并根据这些点找到之前锚定的位置,从而将虚拟物体精确地“放回”原处,这个锚点可以持久化存储,甚至在不同设备间共享,实现协同工作。

第三部分:软件与生态系统 - “灵魂”

硬件是躯体,软件才是灵魂。

- 操作系统: 运行的是 Windows Holographic,这是 Windows 10/11 的一个专门分支,为空间计算进行了深度定制。

- 开发平台:

- Unity: 最主流的开发引擎,通过 Mixed Reality Toolkit (MRTK) 可以轻松构建 HoloLens 应用。

- Unreal Engine: 同样支持 HoloLens 开发,适合制作高质量、高保真的 3D 内容。

- 原生开发: 可以使用 C++ 和 DirectX 进行底层开发,性能最高,但难度也最大。

- 应用场景:

- 工业制造: 远程专家指导、装配流程可视化、质量检测。

- 医疗培训: 在虚拟人体上进行手术模拟。

- 建筑设计: 在建成前,以 1:1 比例在真实空间中预览建筑模型。

- 教育培训: 将抽象的知识(如太阳系、分子结构)可视化。

HoloLens 的“拆机”结论

微软 HoloLens 并不是简单地“把手机戴在头上”,它是一个高度集成的、以空间感知为核心的系统工程。

- 硬件层面: 它以 HPU 为核心,整合了深度传感器、高清光场显示、眼动/手势追踪等一系列尖端硬件,构建了一个强大的空间感知和交互平台。

- 技术层面: 它依靠 SLAM 技术理解世界,通过光场显示创造真实感,利用空间锚点实现虚拟与现实的稳定融合。

- 软件层面: 它依托于 Windows Holographic 生态系统,为企业级应用提供了强大的开发工具和平台。

可以说,HoloLens 的每一次“拆解”,都揭示了其背后对“人机交互”和“计算平台”的深刻思考,它不仅仅是一台设备,更是微软对未来计算平台——空间计算的一次宏伟探索和奠基。