- 模型架构参数:定义你的神经网络结构(如层数、单元数)。

- 训练过程参数:控制模型如何学习(如优化器、学习率、批大小)。

- 全局配置参数:影响 TensorFlow 整体行为的设置(如日志级别、设备选择)。

下面我将详细讲解这三类参数,并提供代码示例。

(图片来源网络,侵删)

模型架构参数

这些参数通常在定义模型时设置,它们决定了模型的能力和复杂度。

常见参数示例 (以 Keras API 为例)

-

Dense层:units: 整数,输出空间的维度(即神经元数量),这是最重要的参数。activation: 激活函数,如'relu','sigmoid','tanh','softmax'。kernel_initializer/bias_initializer: 权重和偏置的初始化方法。kernel_regularizer/bias_regularizer: 权重和偏置的正则化方法。

-

Conv2D层:filters: 整数,输出空间的维度(即卷积核的数量)。kernel_size: 整数或元组,卷积核的宽度和高度。strides: 卷积在输入上滑动的步长。padding:'valid'或'same',决定是否进行填充。

-

LSTM/GRU层: (图片来源网络,侵删)

(图片来源网络,侵删)units: LSTM/GRU 单元的数量。return_sequences: 布尔值,是否返回完整的输出序列(用于堆叠 RNN 层)。

代码示例:

import tensorflow as tf

model = tf.keras.Sequential([

# 输入层,指定输入形状 (28, 28, 1) 代表 28x28 像素的灰度图

tf.keras.layers.Input(shape=(28, 28, 1)),

# 第一个卷积层,32个3x3的卷积核,使用ReLU激活函数

tf.keras.layers.Conv2D(filters=32, kernel_size=(3, 3), activation='relu'),

# 池化层,减少数据维度

tf.keras.layers.MaxPooling2D(pool_size=(2, 2)),

# 将多维数据展平为一维

tf.keras.layers.Flatten(),

# 全连接层,128个神经元,使用ReLU激活函数,并添加L2正则化

tf.keras.layers.Dense(units=128, activation='relu',

kernel_regularizer=tf.keras.regularizers.l2(0.01)),

# Dropout层,防止过拟合,随机丢弃20%的神经元

tf.keras.layers.Dropout(rate=0.2),

# 输出层,10个神经元(对应10个类别),使用softmax激活函数

tf.keras.layers.Dense(units=10, activation='softmax')

])

# 打印模型结构

model.summary()

训练过程参数

这些参数在 model.compile() 和 model.fit() 中设置,它们直接影响模型的训练效果和效率。

A. model.compile() 参数

optimizer: 优化器,用于更新模型权重。- 字符串形式:

'sgd','adam','rmsprop'。 - 类形式:

tf.keras.optimizers.Adam(),tf.keras.optimizers.SGD(),推荐使用类形式,因为它允许你设置更多超参数。

- 字符串形式:

loss: 损失函数,衡量模型预测值与真实值的差距。- 分类问题:

'sparse_categorical_crossentropy'(标签为整数),'categorical_crossentropy'(标签为one-hot向量)。 - 回归问题:

'mean_squared_error'(MSE),'mean_absolute_error'(MAE)。

- 分类问题:

metrics: 评估指标,在训练和测试过程中监控。- 常用:

'accuracy','precision','recall'。

- 常用:

B. model.fit() 参数

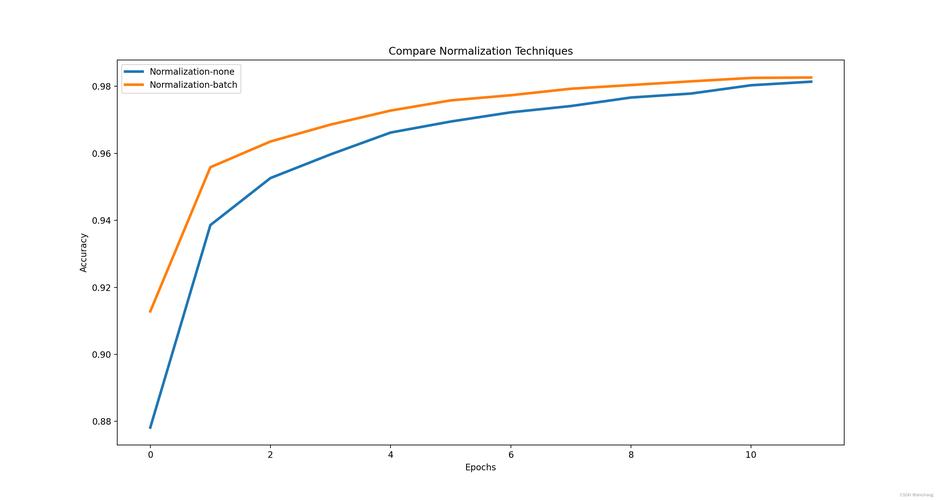

batch_size: 每次梯度更新所使用的样本数。- 影响: 较大的

batch_size训练更快,内存占用更高,但可能收敛到更差的局部最优解,较小的batch_size训练更慢,但泛化能力可能更好。

- 影响: 较大的

epochs: 训练轮数,即遍历整个训练数据集的次数。validation_data: 验证数据集(x_val, y_val),在每个 epoch 结束后,用该数据集评估模型性能,用于监控过拟合。callbacks: 回调函数列表,在训练过程中的不同阶段执行自定义操作,这是非常重要的参数!

C. 优化器 (optimizer) 的关键参数

这是训练中最核心的参数之一。

-

Adam优化器: (图片来源网络,侵删)

(图片来源网络,侵删)learning_rate: 学习率,控制权重更新的步长。这是最重要的超参数!beta_1,beta_2: 一阶和二阶矩估计的指数衰减率。epsilon: 数值稳定性的小常数。

-

SGD(Stochastic Gradient Descent) 优化器:learning_rate: 学习率。momentum: 动量,有助于加速 SGD 并在相关方向上持续前进,减少震荡。

代码示例:

# 1. 编译模型,设置训练参数

model.compile(

optimizer=tf.keras.optimizers.Adam(learning_rate=0.001), # 设置优化器和学习率

loss='sparse_categorical_crossentropy', # 设置损失函数

metrics=['accuracy'] # 设置评估指标

)

# 2. 定义回调函数

# ModelCheckpoint: 保存最佳模型

checkpoint_cb = tf.keras.callbacks.ModelCheckpoint(

"best_model.h5", save_best_only=True, monitor="val_accuracy"

)

# EarlyStopping: 当验证集性能不再提升时,提前停止训练,防止过拟合

early_stopping_cb = tf.keras.callbacks.EarlyStopping(

monitor='val_loss', patience=5, restore_best_weights=True

)

# 3. 训练模型,设置fit参数

history = model.fit(

x_train, y_train, # 训练数据

batch_size=64, # 批大小

epochs=50, # 最大训练轮数

validation_data=(x_val, y_val), # 验证数据

callbacks=[checkpoint_cb, early_stopping_cb] # 使用回调函数

)

全局配置参数

这些参数不直接属于模型或训练,而是配置 TensorFlow 的运行环境,通常在程序开头设置。

常见全局配置

- 日志级别 (

tf.compat.v1.logging): 控制控制台输出的详细程度。tf.compat.v1.logging.set_verbosity(tf.compat.v1.logging.ERROR): 只显示错误信息。tf.compat.v1.logging.set_verbosity(tf.compat.v1.logging.INFO): 显示信息、警告和错误。

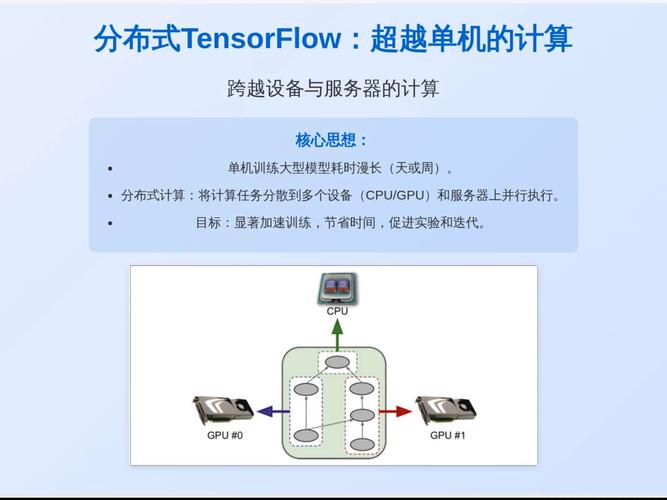

- 设备 placement (

tf.device): 指定操作在哪个设备上运行(CPU, GPU, TPU)。这对于多 GPU 训练至关重要。

- 内存增长 (

tf.config.experimental.set_memory_growth): 允许 GPU 按需分配内存,而不是一开始就占用所有可用内存,这在开发和调试时非常有用。 - 混合精度 (

tf.keras.mixed_precision): 使用float16和float32混合精度进行训练,可以显著减少 GPU 内存占用并加速计算(需要支持 Tensor Core 的 GPU)。

代码示例:

import tensorflow as tf

import os

# 1. 设置日志级别

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2' # 0=所有信息, 1=警告, 2=错误, 3=无

# 或者使用更现代的方式

# tf.get_logger().setLevel('ERROR')

# 2. GPU 内存配置

gpus = tf.config.list_physical_devices('GPU')

if gpus:

try:

# 设置内存按需增长

for gpu in gpus:

tf.config.experimental.set_memory_growth(gpu, True)

print(f"Found {len(gpus)} GPUs and enabled memory growth.")

except RuntimeError as e:

# 内存增长必须在 GPU 初始化之前设置

print(e)

# 3. 混合精度训练 (适用于 Volta 及更新的架构)

# policy = tf.keras.mixed_precision.Policy('mixed_float16')

# tf.keras.mixed_precision.set_global_policy(policy)

# ... 在这里定义和训练你的模型 ...

参数调优策略

设置参数不是一蹴而就的,而是一个迭代优化的过程。

-

学习率 (

learning_rate): 这是最重要的参数。- 太小: 训练极其缓慢,容易陷入局部最小值。

- 太大: 训练过程震荡,甚至发散(损失不降反升)。

- 策略: 从

01,001,0001等常用值开始尝试,使用 学习率调度器 (Learning Rate Scheduler) 在训练过程中动态调整学习率(tf.keras.callbacks.ReduceLROnPlateau)。

-

批大小 (

batch_size):- 受限于你的 GPU/CPU 内存,从

32,64,128开始尝试,选择能让你在单张 GPU 上训练的最大值。

- 受限于你的 GPU/CPU 内存,从

-

正则化 (

Dropout,kernel_regularizer):- 如果模型在训练集上表现很好,但在验证集上表现很差(过拟合),说明模型太复杂,可以增加

Dropout的比例,或者加强 L1/L2 正则化系数。

- 如果模型在训练集上表现很好,但在验证集上表现很差(过拟合),说明模型太复杂,可以增加

-

网络结构 (

units,filters):- 如果模型欠拟合(训练和验证性能都很差),可以尝试增加网络深度(层数)或宽度(每层的单元数/滤波器数)。

- 如果模型过拟合,则相反。

-

使用自动化工具:

- 对于大规模调优,可以使用 KerasTuner 或 Optuna 等超参数优化库来自动搜索最佳参数组合。

| 参数类别 | 关键参数 | 作用 | 设置位置 |

|---|---|---|---|

| 模型架构 | units, filters, kernel_size, activation |

定义网络的结构和容量 | tf.keras.layers 中 |

| 训练过程 | optimizer, loss, metrics |

定义如何学习、如何评估损失 | model.compile() |

batch_size, epochs |

控制训练的批次和轮数 | model.fit() |

|

callbacks |

实现复杂训练逻辑(如早停、模型保存) | model.fit() 的 callbacks 参数 |

|

| 全局配置 | tf.device |

指定运行设备 | 代码块中 |

set_memory_growth |

控制 GPU 内存分配 | 代码开头 | |

mixed_precision |

开启混合精度加速 | 代码开头 |

理解这些参数的含义和它们之间的相互作用,是高效使用 TensorFlow 的关键,建议从简单的默认值开始,然后根据模型的性能表现(训练损失 vs. 验证损失)进行针对性调整。