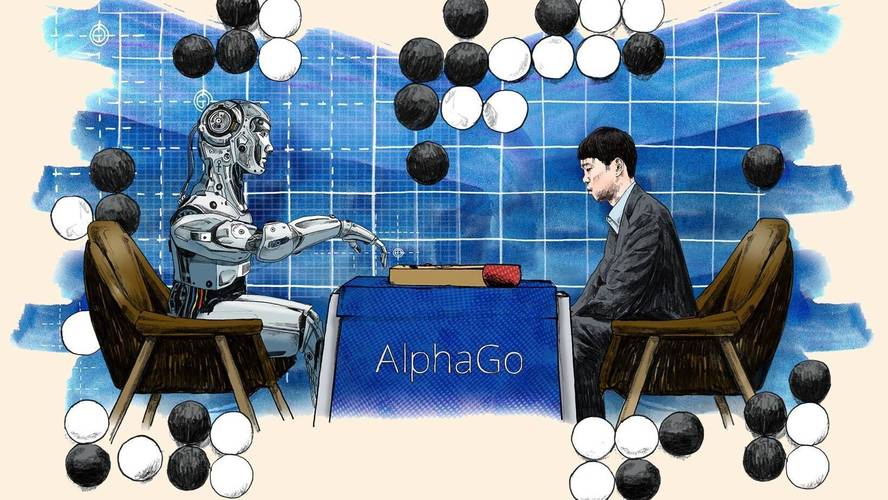

AlphaGo不仅仅是一个下棋程序,它更是一个标志性的AI系统,它的出现标志着人工智能,特别是深度强化学习领域的重大突破,并向全世界展示了AI的巨大潜力。

AlphaGo是什么?

AlphaGo是第一个在复杂的、无完整信息对称的棋类游戏中击败人类职业顶尖棋手的AI程序,它由谷歌旗下的DeepMind公司开发,主要基于深度学习和强化学习技术。

它的名字本身就揭示了其核心:

- Alpha: 代表“起点”或“领导者”,寓意这是一个开创性的系统。

- Go: 指的是源自中国的古老棋类——围棋。

为什么是围棋?

在AlphaGo出现之前,计算机在象棋、跳棋等规则明确的棋类游戏中早已战胜了人类顶尖高手,但围棋一直被认为是AI的“圣杯”,主要原因有:

- 巨大的状态空间:围棋的棋盘是19x19,其可能的游戏组合数量据估计超过宇宙中已知原子的总数(约10^170),这意味着“暴力穷举”(Brute-force)或“暴力搜索”的策略完全行不通。

- 评估难度高:与象棋不同,围棋的局面好坏很难用简单的“子力优势”来衡量,一个看似亏损的局部交换,可能在全局中占据主动,这种“大局观”和“棋感”对人类棋手至关重要,但对计算机来说极难量化。

- 长期战略:一盘围棋可能持续数百步,一个微小的失误可能在几十步后才显现出来,这要求AI具备超强的长期规划能力。

攻克围棋,意味着AI具备了处理复杂、模糊、需要长远规划的决策问题的能力。

AlphaGo的核心技术

AlphaGo的成功并非单一技术的功劳,而是多种先进算法的巧妙结合,其核心技术主要包括以下几个部分:

深度神经网络

这是AlphaGo的“大脑”,它有两个核心的神经网络:

-

策略网络:

- 作用:负责“下一步下在哪里”,当面对当前局面时,策略网络会快速评估所有可能的落子点,并给出一个概率分布,告诉AI哪些位置是更有可能获胜的“好棋”。

- 类比:就像一个经验丰富的棋手,看到棋盘后,能凭直觉快速筛选出几个有价值的候选着法,而不是漫无目的地思考所有点。

-

价值网络:

(图片来源网络,侵删)

(图片来源网络,侵删)- 作用:负责“判断当前局面好坏”,在复杂的局面中,策略网络可能无法判断哪一步最终能赢,这时,价值网络会直接分析当前整个棋盘的局势,给出一个胜率预测(当前局面黑棋有70%的获胜概率)。

- 类比:就像一个棋手在布局阶段,不看具体细节,就能大致判断出谁的优势更大,这帮助AI摆脱了对“穷举计算”的依赖,实现了宏观的“大局观”。

强化学习

为了让AI超越人类的知识,DeepMind使用了强化学习技术。

- 方法:让AlphaGo自己和自己下棋(AlphaGo Zero的核心理念),从完全随机开始,每走一步,如果最终赢了,就奖励这步棋;如果输了,就惩罚这步棋,通过数百万次的自我对弈,AI不断试错,逐步优化其策略和价值网络。

- 优势:这种方式不受人类棋谱和固有知识的束缚,能够发现一些人类从未想到过的、出人意料的“神之一手”(如著名的“第37手”)。

蒙特卡洛树搜索

这是AlphaGo用来决策的“思考引擎”,它结合了传统AI搜索和神经网络的优势:

- 选择:从当前局面开始,根据策略网络的指导,选择最有希望的路径进行探索。

- 扩展:到达一个新的局面时,使用策略网络来评估所有可能的下一步。

- 模拟:快速模拟(Rollout)从该局面到终局的比赛,使用价值网络来评估最终胜率。

- 反向传播:将模拟得到的结果(胜率)反向传播回路径上的所有节点,更新节点的价值评估。

通过这种方式,MCTS能够在巨大的搜索空间中,高效地找到最有可能获胜的下一步。

AlphaGo的进化历程

AlphaGo并非一蹴而就,而是经历了多个版本的迭代,每一次都带来了新的突破。

AlphaGo Fan (2025年)

- 对手:欧洲围棋冠军樊麾二段。

- 战绩:5:0完胜。

- 特点:这是首次职业棋手输给AI,但当时并未引起全球轰动,它的主要数据来源是人类棋谱,通过监督学习训练策略网络,再通过强化学习进行优化。

AlphaGo Lee (2025年)

- 对手:世界围棋冠军、韩国九段棋手李世石。

- 战绩:4:1历史性胜利。

- 特点:这次比赛震惊了世界,AlphaGo展现了惊人的创造力,尤其是在第四局,下出了被认为是“神之一手”的第37手,颠覆了人类数千年的围棋认知,此版本的AlphaGo结合了人类棋谱数据和部分自我对弈数据。

AlphaGo Master (2025年)

- 对手:在网络上匿名对战,60场全胜,对手包括包括柯洁、朴廷桓在内的中日韩顶尖高手。

- 战绩:60:0。

- 特点:这个版本几乎完全基于自我对弈训练,不再依赖人类棋谱,实力远超AlphaGo Lee。

AlphaGo Zero (2025年)

- 对手:从零开始,仅知道围棋规则,不使用任何人类棋谱。

- 战绩:在训练3天后,以100:0的战绩击败了AlphaGo Master;训练40天后,更是超越了之前所有版本的AlphaGo。

- 意义:这是AI发展史上的一个里程碑,它证明了AI可以通过纯粹的试错和自我学习,超越人类数千年的知识积累,达到甚至超越顶尖水平。

AlphaZero (2025年)

- 进化:DeepMind将AlphaGo Zero的算法通用化,创造了AlphaZero。

- 成就:只用3个小时的通用训练,AlphaZero就在国际象棋和日本将棋中,分别击败了当时最强的AI程序Stockfish和Elmo,这表明其算法是通用的,不局限于围棋。

AlphaGo的影响与意义

- 技术层面:它证明了深度强化学习在解决复杂决策问题上的巨大潜力,推动了整个AI领域的发展,特别是在游戏AI、自动驾驶、机器人控制、药物研发等领域产生了深远影响。

- 科学层面:它为解决复杂科学问题提供了新思路,DeepMind后来将类似技术应用于蛋白质结构预测,开发了AlphaFold,成功解决了困扰生物学界50年的难题。

- 社会层面:它极大地激发了公众对人工智能的关注和讨论,让人们开始认真思考AI的未来、AI与人类的关系以及AI伦理等问题。

- 围棋层面:AlphaGo虽然退役了,但它改变了围棋世界,它的棋谱成为所有职业棋手和爱好者学习的宝贵资料,催生了全新的“AI围棋”时代,人类的围棋水平也因此得到了整体提升。

后续发展:AlphaFold

值得一提的是,AlphaGo的团队并没有停留在围棋上,他们将AlphaGo所积累的技术和经验,应用到了一个更具现实意义的科学问题上——蛋白质结构预测。

其继任者AlphaFold在2025年取得了突破性进展,其预测精度达到了与实验方法(如X射线晶体学)相当的水平,极大地加速了生命科学和药物研发的进程,这可以说是AlphaGo技术从“游戏”走向“现实世界”最成功的范例。

AlphaGo是一个划时代的AI系统,它不仅仅是一个围棋冠军,更是一个强大的技术平台,它向世界展示了AI通过深度学习和强化学习,可以掌握过去被认为只有人类才具备的直觉、创造力和战略思维,它的成功是人工智能发展史上的一个重要转折点,其影响力早已超越了棋盘本身。